Stable Diffusion: Pemahaman Mendalam tentang Teknologi Pembuatan Gambar AI

Stable Diffusion merupakan salah satu teknologi generator Artificial Intelligence (AI) yang mempermudah manusia dalam menciptakan karya seni dua dimensi hingga 3D. Dengan teknologi ini, pengguna dapat menghasilkan gambar hanya dengan menggunakan perintah teks sederhana. Tertarik untuk mengetahui lebih lanjut tentang bagaimana sistem AI Stable Diffusion ini bekerja? Artikel ini akan membahas informasi tersebut secara mendalam dan memberikan panduan efektif dalam penggunaannya. Simak penjelasannya di bawah ini.

Stable Diffusion adalah teknologi AI generatif yang memiliki kemampuan menghasilkan gambar realistik dan unik berdasarkan perintah teks dan gambar prompt. Kelebihan situs ini adalah bersifat open source, memberikan fleksibilitas penggunaan yang tinggi. Melalui teknologi ini, pengguna dapat melatih sistem untuk menciptakan gambar realistis berdasarkan deskripsi yang diberikan.

Seperti halnya dengan generator AI lainnya, Stable Diffusion juga mengandalkan algoritma untuk menghasilkan beragam gambar dan foto artistik, termasuk karya dengan orientasi landscape, potret, dan seni abstrak. Selain itu, situs ini memiliki potensi untuk mendukung karya dalam penelitian ilmiah, menciptakan seni digital, dan mengembangkan video game. Bagaimana sebenarnya cara kerjanya? Untuk informasi lebih lanjut, mari kita cek uraiannya pada bagian berikutnya.

Baca Juga: Cara Menggunakan Bing Image Creator

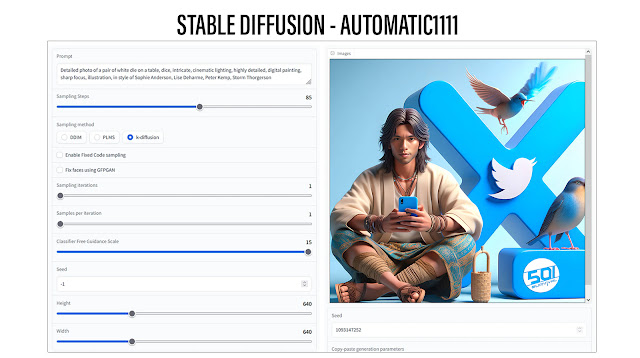

Cara Kerja Stable Diffusion

Cara kerja Stable Diffusion berbeda dari banyak model pembuatan gambar lainnya. Prinsipnya, generator AI ini mengadopsi teknologi Noise Gaussian untuk menghasilkan kode gambar. Setelah itu, sistem menggunakan prediktor noise untuk meresapi gambar sesuai dengan perintah yang diberikan. Yang membedakan, kualitas gambar atau foto Stable Diffusion tidak bergantung pada piksel, melainkan menggunakan ruang laten volume rendah.

Tujuan dari pendekatan ini adalah untuk mempercepat penghasilan gambar sesuai kebutuhan pengguna. Keuntungan lainnya adalah kemampuan ruang laten untuk menghasilkan gambar yang lebih rinci dan halus. Dengan konsep ini, Stable Diffusion dapat digunakan pada perangkat dengan kartu grafis NVIDIA dan RAM minimal 6GB atau direkomendasikan 8GB hingga lebih.

Karena gambar berwarna resolusi 512x512 memiliki 786.432 kemungkinan nilai, sementara Stable Diffusion menggunakan gambar terkompresi 48 kali lebih kecil pada 16.384 nilai, secara signifikan mengurangi persyaratan pemrosesan. Ini memungkinkan penggunaan Stable Diffusion pada desktop dengan GPU NVIDIA dan RAM 8 GB. Ruang laten yang lebih kecil efektif karena gambar alami tidak acak. Stable Diffusion menggunakan file enkoder otomatis variasional (VAE) dalam dekoder untuk menggambarkan detail halus, seperti mata.

Stable Diffusion V1 dilatih dengan tiga set data yang dikumpulkan oleh LAION melalui Common Crawl, termasuk set data gambar LAION-Aesthetics v2.6 dengan peringkat estetika 6 atau lebih tinggi.

Stable Diffusion mampu menghasilkan gambar dari berbagai perintah, mulai dari teks ke gambar, gambar ke gambar, karya seni grafis, hingga pengeditan gambar dan pembuatan video. Penyajian perintah dapat disimak lebih lanjut pada ulasan berikutnya untuk memahami cara optimal menggunakan Stable Diffusion.

Arsitektur yang digunakan Stable Diffusion

Komponen arsitektur utama Stable Diffusion melibatkan enkoder otomatis variasional, difusi maju dan mundur, prediktor noise, dan pengondisian teks.

- Enkoder Otomatis Variasional

Enkoder otomatis variasional terdiri dari enkoder dan dekoder terpisah. Enkoder memampatkan gambar 512x512 piksel menjadi model 64x64 yang lebih kecil dalam ruang laten yang mudah dimanipulasi. Dekoder mengembalikan model dari ruang laten ke gambar ukuran penuh 512x512 piksel.

- Difusi Maju

Difusi maju secara progresif menambahkan noise Gaussian ke gambar hingga hanya tersisa noise acak. Identifikasi gambar tersebut dari noise akhir menjadi tidak mungkin. Difusi maju digunakan selama konversi gambar ke gambar, di mana setiap gambar melalui proses ini selama pelatihan.

- Difusi Mundur

Proses ini berupa proses berparameter yang secara iteratif membatalkan difusi maju. Misalnya, pelatihan model dapat melibatkan miliaran gambar dan menggunakan prompt untuk menciptakan gambar unik dengan memanfaatkan proses ini.

- Prediktor Noise (U-Net)

Prediktor noise kunci untuk melakukan denoising gambar, menggunakan model U-Net, jaringan neural konvolusional awalnya dikembangkan untuk segmentasi gambar biomedis. Stable Diffusion menggunakan model Jaringan Neural Residual (ResNet) yang dikembangkan untuk penglihatan komputer. Prediktor noise mengurangi noise dari gambar dengan mengulangi proses ini beberapa kali sesuai langkah-langkah yang ditentukan pengguna dan sensitif terhadap prompt pengondisian.

- Pengondisian Teks

Bentuk pengondisian umumnya menggunakan prompt teks. Tokenizer CLIP menganalisis setiap kata dalam prompt tekstual dan menyematkan data ini ke dalam vektor nilai 768. Stable Diffusion memberikan umpan pada prompt ini dari enkoder teks ke prediktor noise U-Net menggunakan transformator teks. Dengan mengatur angka awal ke generator angka acak, pengguna dapat menghasilkan gambar yang berbeda di ruang laten.

Apa saja yang bisa dilakukan Stable Diffusion?

Stable Diffusion mewakili kemajuan penting dalam pembuatan model teks ke gambar, dengan ketersediaannya secara luas dan membutuhkan daya pemrosesan yang lebih efisien dibandingkan banyak model sejenis. Fungsionalitasnya mencakup pembuatan gambar dari teks, konversi gambar ke gambar, penghasilan karya seni grafis, pengeditan gambar, dan pembuatan video.

- Pembuatan Teks ke Gambar:

Stable Diffusion paling sering digunakan untuk menghasilkan gambar melalui prompt tekstual. Variasi gambar dapat dicapai dengan penyesuaian angka awal untuk generator acak atau modifikasi jadwal denoising.

- Pembuatan Gambar ke Gambar:

Dengan memanfaatkan gambar input dan prompt teks, Stable Diffusion memungkinkan penciptaan gambar berdasarkan gambar awal. Contoh umum adalah menggabungkan sketsa dengan prompt yang relevan.

- Pembuatan Grafis, Karya Seni, dan Logo:

Dengan memilih prompt yang tepat, pengguna dapat menciptakan karya seni, grafik, dan logo dalam berbagai gaya. Meskipun hasil akhir seringkali tidak dapat diprediksi, sketsa dapat membimbing proses pembuatan logo.

- Pengeditan dan Perbaikan Gambar:

Stable Diffusion berguna untuk mengedit dan memperbaiki foto dengan menggunakan Editor AI. Pengguna dapat menghapus atau mengubah area pada gambar dengan menggunakan kuas penghapus dan mencapai hasil yang diinginkan dengan prompt yang relevan. Ini dapat mencakup perbaikan foto lama, penghapusan objek, perubahan fitur subjek, dan penambahan elemen baru.

- Pembuatan Video:

Dengan dukungan dari fitur seperti Deforum dari GitHub, Stable Diffusion memungkinkan pembuatan klip video pendek dan animasi. Penggunaan lain melibatkan penambahan gaya unik ke film, serta kemampuan untuk memberikan foto kesan gerak, seperti air yang mengalir.

Baca Juga: Memahami Teknologi AI Text-to-Image: Saat Kata-kata Menjadi Gambar

Dalam teknologi yang semakin berkembang, kini semua orang dapat menjadi seorang seniman dengan bermodalkan imajinasi saja. Dengan memasukkan teks atau kalimat sederhana yang kalian inginkan, maka mesin AIakan membuatkan karya seni, ilustrasi, dan gambar dengan hasil profesional.

Komentar

Posting Komentar